Великі дані виросли з концепції і яскравого терміна в набір технологій, архітектур і додатків, які, суміщені з сучасною аналітикою, надають практично необмежені можливості для оптимізації процесів, бізнесу, а також відкривають нові можливості для наукових досліджень. А за деякими даними, ця технологія забезпечили перемогу Трампу і Brexit. Дана стаття пропонує короткий структурований огляд розвитку цієї галузі і тенденцій створення інфраструктури обміну і обробки даних, які можна визначити як майбутній Інтернет (великих) даних. Стаття наводить приклади стандартизації, проектів та ініціатив для забезпечення доступності, виявленості і сумісності даних.

Вступ

Великі дані (ВД) є усталеним терміном і як концепція позначають дані надзвичайно великого обсягу, недоступні обробці традиційними програмними засобами з реалістичними термінами. До характеристик БД відносять їх обсяг, швидкість генерації та обробки, а також ступінь різноманітності типів і природи даних. Від БД невіддільні технології їх обробки та аналізу, широко використовувані практично у всіх областях діяльності людини і частині бізнес-процесів сучасних фірм. Великі дані є результатом сучасних бізнес-процесів, промислових і технологічних процесів, а також соціальної активності людини в соцмережах. На рівні обчислювальних і комунікаційних технологій/процесів дані представляють собою основний продукт, мету та інструмент роботи більшості додатків і процесів. Великі дані, суміщені з сучасною аналітикою, надають практично необмежені можливості для оптимізації процесів, а також відкривають нові можливості для наукових досліджень. Широке використання даних в бізнесі привели до появи так званих підприємств, керованих (і залежних від) даними (Agile Data Driven Enterprise), те ж саме відбувається з сучасною наукою, яка стає також залежною від даних і все більше використовує методи досліджень на основі інтенсивного аналізу даних (Data Driven Science and Research).

Розвиток технологій та інфраструктури великих даних привів до появи науки про дані (Data Science) і сильно стимулювало розвиток хмарних обчислень (Cloud Computing), які спільно змогли забезпечити необхідні ресурси і платформу/ресурси для обробки, зберігання та передачі/обміну великих даних. У свою чергу, розвиток інфраструктури великих даних і хмарних обчислень привів до значних змін в тому, як працює і розвивається сучасний Інтернет. Багато ветеранів-дослідників Інтернету, а також професійні організації в області телекомунікаційних технологій (таких як ITU-T, TMForum) бачать тенденцію еволюції сучасної телекомунікаційно-інформаційної інфраструктури від Інтернету до Інтернету речей і до Інтернету даних. Більшість сучасних додатків в явному або неявному вигляді використовують елементи розподіленої і глобальної інфраструктури даних, по суті, Інтернету даних. Ми можемо очікувати безліч інновацій і додатків на цьому технологічному рівні, які повинні забезпечити можливість глобального обміну, інтеграції і навіть торгівлі даними за умови дотримання суверенності, довірливості і захисту персональних даних, таких як GDPR. Безліч ініціатив існує в цій області в Європі і в світі, включаючи підтримку Європейської рамкової програми Horizon 2020.

Властивості великих даних

Перші визначення великих даних були запропоновані у 2011 році. Визначення аналітичної фірми IDC можна розглядати як досить консервативне: «Нове покоління технологій і архітектур, призначених для економічно ефективного видобування корисної значимої інформації з великої кількості різноманітних даних за допомогою ефективного збору, виявлення і аналізу» (IDC, 2011).

Аналітична фірма Gartner запропонувала визначення великих даних як інформаційних активів великого обсягу, високої швидкості, великої різноманітності, які вимагають нових ефективних форм обробки інформації для поліпшеного розуміння і прийняття рішень (Gartner, 2011). Таке визначення фактично посилається на «основні 3V» великих даних (Volume, Velocity, Variety - Обсяг, Швидкість, Різноманітність), вказує на нові методи аналітики, необхідність враховувати цільове використання БД.

Однак, найбільш популярним стало визначення від Forrester Research (2013): «Великі дані представляють масивний об'єм структурованих і не структурованих даних, які настільки великі, що їх складно обробляти, використовуючи традиційні бази даних і програмні засоби». Ефективність такого визначення, що з'явився в той час, коли з'явилися перші засоби для роботи з великими даними і намітилися певні тенденції в області розробки і застосування БД, в основному пов'язана з розробкою нереляційних баз даних (NoSQL), засобів зберігання БД і масштабованих засобів масивної обробки, таких як MapReduce, Hadoop, Spark.

Спочатку БД характеризувалися трьома основними властивостями, так званими 3V. Надалі до базових 3V додалися властивості великих даних, які вони набувають в процесі обробки і які є основоположними для визначення вимог до систем обробки великих даних: Value, Variability, Veracity (Значимість, Мінливість, Конфіденційність).

Цей малюнок представляє графічно базові і придбані властивості БД, які складають 6V великих даних; також на малюнку перераховані основні характеристики, які відносяться до відповідних властивостей.

Однак швидкий розвиток і впровадження технологій БД в бізнес і промисловість було вже добре підготовлено розвитком систем і платформ для наукових досліджень, які створили передумови для реалізації нових методів наукових досліджень, які були визначені вченим в області комп'ютерних наук Джимом Греєм (Jim Gray) як четверта парадигма наукових досліджень: «Засоби і технології для такої наукомісткої науки, керованої даними, є настільки іншими, що є сенс відрізняти науку, керовану даними від обчислювальної/комп'ютерної науки як нову четверту парадигму наукових досліджень». (Grey, 2010) Третя парадигма наукових досліджень вже використовувала обчислювальні технології, але в основному для моделювання і симуляції наукових теорій і моделей, розроблених класичними теоретичними (аналітичними) і експериментальними науковими методами. До моменту написання книги Грея наука вже стояла перед завданнями, які мали справу з великими обсягами даних і вимагали нової інфраструктури для обробки експериментальних даних, включаючи забезпечення співпраці великої кількості всесвітньо/глобально розподілених груп вчених.

Приклади застосування великих даних в науці і промисловості

Давайте розглянемо приклади використання великих даних в науці і техніці, які створили передумови і стимулювали розвиток технології БД.

Великий адронний прискорювач LHC і інфраструктура великих даних LCG

В першу чергу застосування БД відноситься до глобального міжнародного проекту по виявленню частки Хіггса, бозона, для чого в 2008 році було закінчено будівництво найбільшого наукового інструменту - Великого адронного прискорювача (Large Hadron Collider, LHC) в ЦЕРНі в Швейцарії. Будівництво прискорювача зайняло кілька років і вимагало не тільки співпраці вчених з усього світу, а й рішення нових завдань збору, зберігання, поширення і обробки експериментальних даних, вироблених датчиком зіткнення пучків протонів ALICE, розігнаних до швидкості світла. Фактично саме зіткнення частинок триває протягом 10 мс, швидкість виробництва даних становить одиниці РВ (Petabyte) в секунду. Сумарна кількість даних, вироблених в експериментах протягом місяця, складає більше 10 РВ, дані повинні бути зібрані/зареєстровані, первинно оброблені, збережені в центрах зберігання даних першого рівня і поширені до рівня регіональних наукових центрів обробки даних по всьому світу. Обробка всього обсягу експериментальних даних не могла бути виконана засобами одного обчислювального центру в той час (та й зараз це теж неможливо). Таким чином, випадок LHC демонструє приклад двох найважливіших властивостей великих даних: великий обсяг і велика швидкість, - і технічні завдання, які пов'язані з цим. Як відомо, робота прискорювача і глобальне співробітництво дослідників усього світу увінчалися успішним відкриттям бозона в 2013 році.

Для створення інфраструктури обробки даних, вироблених прискорювачем, міжнародне співтовариство фінансувало кілька проектів по створенню Worldwide LHC Grid (WLCG), які включали проект EGEE (Enabling Grids for E-sciencE), фінансований європейськими рамковими програмами FP6-FP7 в 2004-2010, проект Open Science Grid в США, фінансований країнами-учасниками проекту. В даний час інфраструктура європейського гріда підтримується асоціацією «Європейська грід-ініціатива» (EGI - European Grid Initiative) 5 спільно з координаційними органами у всіх європейських країнах. EGI надає обчислювальні ресурси (як суперкомп'ютерів, так і хмарних центрів даних) практично для всіх наукомістких європейських наукових проектів, а також продовжує розвиток інфраструктурних сервісів грід, які в даний час працюють на основі стандартних хмарних платформ.

Результатом проекту EGEE і відповідного міжнародного співробітництва було не тільки створення власне інфраструктури для обробки наукових даних, але і фактично прискорення появи таких нових напрямків в області обчислювальних та інформаційних технологій як Web Services (включаючи SOAP- і REST-протоколи), обчислювальні гріди (Computer Grids ) і модель управління обчислювальними завданнями в розподілених центрах даних, федеративна модель управління ідентифікацією користувачів і федеративний доступ до мережевих обчислювальних ресурсів і даних.

Багато ідей щодо доступу та інтеграції даних, спочатку запропоновані в комп'ютерних грід-системах, були розвинені в сучасній архітектурі хмарних обчислень (Cloud Computing) і федеративного доступу до розподілених сервісів. Це також стимулювало широку міжнародну стандартизацію, метою якої є забезпечення ефективного доступу до розподілених обчислювальних ресурсів, включаючи забезпечення безпеки даних. Інший напрямок стандартизації включають розробку методів і форматів опису, ідентифікації та пошуку даних, таких як метадані, постійні/глобальні ідентифікатори (PID - Persistent Identifiers), довірчі розподілені обчислювальні моделі.

Великі дані в промисловості і бізнесі

Промислові процеси і машини в даний час повністю комп'ютеризовані і автоматизовані, що призводить до генерування великої кількості даних, які необхідно зберігати і обробляти для оптимізації процесів і - в кінцевому підсумку - для збільшення безпеки і зменшення витрат. Промисловий Інтернет речей (Industrial Internet of Things) в даний час включає в себе і спирається на такі технології як хмарні обчислення, граничні обчислення (Edge Computing), автоматизація та промислові роботи, штучний інтелект і цифрові двійники (Digital Twins), в основі яких лежить робота з великим обсягом різноманітних даних, що вимагають швидкої обробки для управління процесами або прийняття рішень. Перерахований комплекс технологій висуває свої вимоги до інфраструктури великих даних, які включають крім загальних вимог до зберігання, обробки і доступу до великих даними додаткові вимоги по захищеному обміну даними, стандартизації опису даних, якості даних, зберігання історії даних тощо.

В авіаційній промисловості збір і зберігання даних про роботу всіх систем літака є основою прогнозного моніторингу, який загальновизнано дозволяє істотно знизити вартість обслуговування літака і підвищити безпеку. Відомо, що чотиримоторний літак Boeing 747 Jumbo виробляє 640 Тбайт даних за час трансатлантичного перельоту, і все це повинно бути помножена на більш ніж 25 тисяч польотів кожен день. У разі інциденту дані про потрібні системи повинні бути вилучені і оброблені, використовуючи необхідні методи машинного аналізу даних. Якість аналізу і діагностики залежить у великій мірі від цифрової моделі літака (по суті, цифрового двійника) і якості даних. Характерна ситуація в розслідуванні авіаційних інцидентів вимагає обміну даними між різними організаціями і фірмами, часто конкуруючими, і це вимагає створення відповідної інфраструктури для довірчого обміну даними і безпечної довірчої середовища обробки, яка б захищала як вхідні і вихідні дані, так і алгоритми, які також можуть представляти комерційну таємницю.

Класичним прикладом використання великих даних є пошукові системи. Пошукова система Google, яка є абсолютним домінантом на ринку пошукових систем, використовує всі найкращі системи і алгоритми для обробки БД з метою надання якісних результатів (і в найкоротший термін), очікуваних користувачами. Результатом досліджень в Google та інших фірмах в області пошукових систем і інфраструктури БД стала поява відкритого програмного забезпечення для обробки великих даних, такого як Hadoop, MapReduce, HBase, Pig, Hive, які складають основу сучасних технологій великих даних. Всі зазначені програми дозволяють працювати з глобально розподіленими даними в масштабі Інтернету.

Крім основного бізнесу надання пошукових результатів, пошукові системи і Google, зокрема, надають платні цільові оголошення/рекламу, яка є однією з основних форм заробляння грошей на пошуковому бізнесі. Таргетована реклама (англ. Targeted advertising) включається в сторінку пошукових результатів на основі контексту запиту, історії запитів користувача або додатково інших даних про користувача, що збираються пошуковою системою. Але критично важливим критерієм для ефективності такої реклами є її включення у відповідну сторінку протягом 40 мс після отримання запиту, в іншому випадку увагу користувача буде переключено на власне результати пошуку. Оптимальне рішення цього завдання є однією з проблем як алгоритмів обробки даних, так і побудови самої інфраструктури даних.

Інші приклади використання великих даних в науці і промисловості

Дослідження генома і генетичні дослідження в загальному є одним із прикладів використання різних аспектів великих даних, включаючи обробку даних секвенування генома, зберігання еталонного геному і доступ до нього, а також зберігання індивідуальних геномів при масових дослідженнях. Згідно з різними оцінками, повне секвенування індивідуального геному людини виробляє близько 250 Гбайт вихідних даних (власне об'єм генома оцінюється в 4,23 Гбайт), наступна обробка з метою діагностики може потребувати доступу до геномних баз даних і виробляти додатково великий обсяг даних. Ефективне використання цих даних для наукових досліджень і в медичних цілях ставить завдання створення спеціальної інфраструктури геномних даних, яка б дозволяла семантичний пошук по шаблонах і доступ до необхідних частин генома.

У Європі створено спеціальну організацію ELIXIR, яка координує європейські проекти з дослідження геному і підтримує інфраструктуру для доступу до баз даних геномів, включаючи еталонний геном людини, додатки для геномних досліджень, обчислювальні ресурси. Одним із завдань інфраструктури ELIXIR є розподіл і обслуговування реплік бази даних геномів від центральної бази даних до національних баз даних і тих, які використовуються в великих дослідних центрах, включаючи контроль доступу, якість і захист даних.

Еталонна архітектура систем великих даних і інші стандарти

Робота з розподіленими і різноманітними даними великих обсягів з самого початку зажадала стандартизації на рівні інфраструктури, опису та ідентифікації даних, що стало предметом роботи багатьох організацій по стандартизації, як міжнародних, так і національних або галузевих, загальний напрямок яких можна визначити як створення Інтернету (великих) даних. У цьому розділі ми розглянемо еталонну архітектуру великих даних (NIST Big Data Reference Architecture, NBDRA), запропоновану NIST (National Institute of Standards and Technologies), а також роботи Research Data Alliance (RDA), спрямовані на створення стандартів опису даних, визначення метаданих, а також визначення постійних ідентифікаторів PID (Persistent Identifier) даних з відповідною інфраструктурою.

Еталонна архітектура систем великих даних NIST

Стандарт NIST SP1500 включає три головні компоненти: визначення концепції/парадигми великих даних, визначення еталонної архітектури великих даних, визначення фахівця за даними (Data Scientist) як нову професію (NBDRA, 2020).

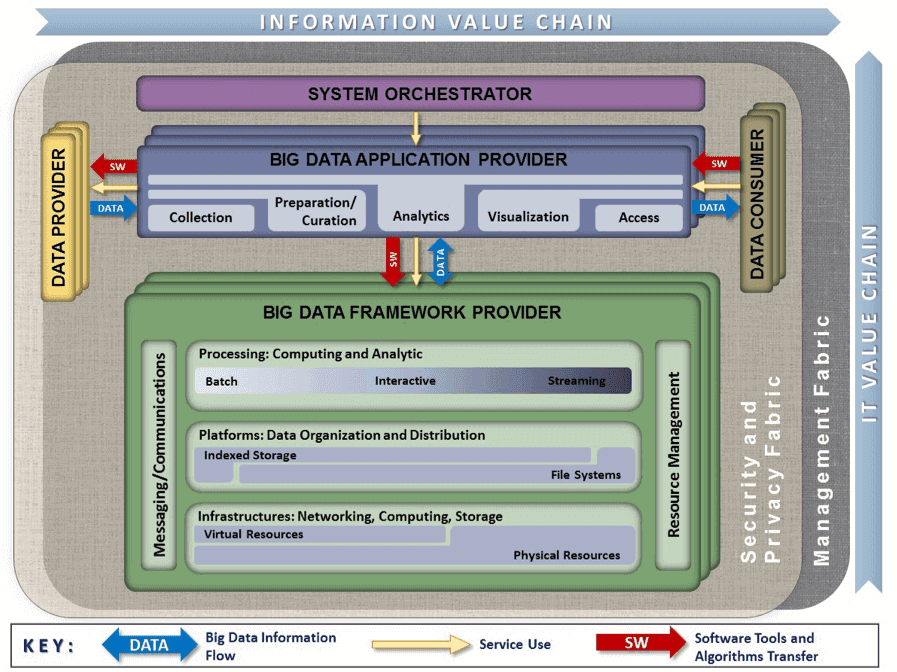

Малюнок зображує запропоновану архітектуру, яка включає головні функціональні компоненти, згруповані по відношенню до основних функціональних ролей в екосистемі великих даних: провайдер інфраструктури і платформ великих даних (Big Data framework provider), провайдер додатків великих даних (Big Data application provider), системний інтегратор (system orchestrator), а також провайдери (data provider) і споживачі (data consumer) даних. Платформа і інфраструктура великих даних включає, по суті, хмарні інфраструктурні сервіси, платформу управління даними, включаючи реляційні і нереляційні (SQL/NoSQL) бази даних, а також платформи і засоби для аналізу великих даних, такі як Hadoop і Spark, з відповідними компонентними сервісами.

Група функцій, що відноситься до провайдера додатків великих даних, включає основні функції процесу обробки або життєвого циклу даних: збір даних, підготовка, аналіз, візуалізація та презентація результатів кінцевого споживача, яким може бути як людина, так і процес. NBDRA також включає загальні функції управління ресурсами і процесами, інфраструктуру безпеки і обміну повідомленнями.

NBDRA побудована в двох координатах: ланцюжок створення значущості даних від збору даних до цільового використання та інфраструктурні рівні обробки даних від загальних комп'ютерних або хмарних ресурсів до спеціалізованих платформ для аналізу даних.

Більш широке визначення архітектури систем великих даних має також включати визначення формальних моделей великих даних, включаючи формати і ідентифікатори даних, метадані, семантичні моделі, які важливі для межсистемного і міжплатформного обміну, інтеграції та сумісності даних (BDAF, 2014 року).

Фабрики даних і постійні ідентифікатори даних PID

Група Data Fabric Interest Group (IG-DF) в RDA ставить своїм завданням визначення загальних компонентів і сервісів, характерних для типових процесів створення та використання даних в щоденній практиці наукових і промислових лабораторій, з метою створення умов використання та інтеграції даних з різних областей для реалізацій міждоменних і міжгалузевих досліджень. Глобальною метою IG-DF є створення Інтернету даних як інфраструктури для обміну науковими даними в процесі всіх етапів обробки даних з тією ж простотою, як це відбувається зі звичайними даними в Інтернеті. На початковому етапі своєї роботи IG-DF детально дослідила досвід створення і розвитку Мережі і залучала експертів, які мають досвід розробки інтернет-стандартів і активно працюють з IETF (Internet Engineering Task Force).

Результатом роботи IG-DF і відповідних робочих груп стала розробка регістру типів даних, директорії метаданих, постійних ідентифікаторів даних PID (Persistent Identifier). Передбачається, що PID зможе виконувати таку ж роль для ідентифікації, пошуку і доступу до даних, яку IP і доменні адреси грають для доступу до всіляких ресурсів в Інтернеті.

Загальні вимоги до інфраструктури великих даних

Для вирішення завдань ефективної обробки даних з метою отримання максимальної користі з доступних даних і оптимізації процесів, які залежать від даних і керуються ними, майбутня інфраструктура великих даних повинна володіти рядом властивостей (відповідати ряду вимог), таких як:

- широка автоматизація всіх процесів обробки і управління даними, включаючи надання ресурсів і сервісів на вимогу (provisioning on demand), характерних для хмарних сервісів;

- перетворення всіх процесів управління інфраструктурою і процесами в цифрову форму (digitalisation), постійний моніторинг і реєстрація етапів перетворення даних;

- можливість повторного використання даних, включаючи повторне використання для інших цілей і змішування з відкритими даними, одним з важливих джерел яких є соціальні мережі і медіа;

- глобальний доступ до даних для співпрацюючих проектів і груп дослідників, в першу чергу стосується наукових даних і наукового співробітництва;

- поліпшена безпека інфраструктури та захисту даних, включаючи персональні дані, на основі сучасних механізмів і сервісів безпеки, федеративного управління ідентифікацією користувачів і сервісів.

Істотно, щоб майбутня інфраструктура великих даних (фактично майбутній Інтернет даних) забезпечувала довірче середовище для обміну даними і підтримувала суверенність даних в тому сенсі, щоб власник/правовласник даних зберігав контроль над використанням даних, що є принципово важливим для промислових даних.

Інші ініціативи в напрямку побудови Інтернету великих даних

Питання обміну даними є важливим як для науки, так і для промисловості. Однією з таких ініціатив є GO FAIR Data Initiative по впровадженню принципів FAIR (Findable, Accessible, Interoperable, Reusable) для забезпечення виявленості, доступності, сумісності та повторного використання в першу чергу наукових даних, спочатку запропонована європейським науковим співтовариством і в даний час підтримувана всесвітньо, зокрема, RDA і низкою проектів, що фінансуються в рамках європейської рамкової програми Horizon 2020 EOSC (European Open Science Cloud) і FAIRsFAIR.

Важливою ініціативою щодо визначення принципів довірчого обміну промисловими даними і створення елементів інфраструктури обміну промисловими даними є створення International Data Spaces Association (IDSA), яка на даний момент об'єднує понад 100 організацій від промисловості, науки і університетів. Еталонна архітектура, запропонована IDSA, передбачає використання сучасних хмарних технологій і визначає ключові функціональні компоненти для забезпечення довірчого обміну і використання промислових даних на основі принципу суверенності даних (Data Sovereignty).

Висновок

Ефективне використання БД є важливим рушійним фактором сучасних технологій. Більшість додатків БД використовують дані з різних джерел, що включають як вихідні дані (наприклад, вироблені системою датчиків або соціальними медіа), так і спеціальні набори даних, підготовлених і оброблених іншими додатками, або дані, які використовуються як еталонні (такі як дані геномів, зоряна база даних або набори даних для навчання алгоритмів штучного інтелекту). Ефективний доступ до таких даних, які в більшості є розподіленими, викликають необхідність побудови інфраструктури доступу та обміну даними або, іншими словами, майбутнього Інтернету даних, на створення якого направлено багато проектів і ініціатив у всьому світі. Створення майбутнього відкритого Інтернету даних сприятиме подальшому розвитку технологій і додатків, заснованих на даних.

Створення Інтернету даних за принципом Інтернету, а також підтримування FAIR-принципів обміну даними створить умови, при яких більше організацій будуть готові обмінюватися своїми даними за допомогою відкритих сервісів обміну даними або ринків даних.

Обробка: Vinci