Google Search Console (Google Webmaster Tool) - невід'ємний інструмент SEO-оптимізатора, що працює з будь-якою пошуковою системою. GSC знаходить десятки технічних помилок, які заважають просуванню в пошукових системах, а також допомагає отримати статистику по запитам і знайти недооптимізовані сторінки з низьким CTR.

Важливо пам'ятати, що консоль - просто інструмент, який підказує слабкі місця. Показники краще аналізувати, використовуючи сервіси гугл, паралельно з даними, отриманими з парсеру або логів (якщо шукаєте дублі метаданих, сторінки не в індексі та інше), а також з інших сервісів аналітики. Ігнорувати сервіси гугл вебмайстер тулс не варто, щоб не упустити критичні помилки, які вплинуть на місце в пошуковій видачі.

У цьому пості розглянемо звіти Google Search Console (як старої, так і нової версії) і розповімо, як вони допомагають в роботі SEO-оптимізатора.

1. Звіти першорядної важливості

1.1. Звіт про ефективність

Цей звіт один з найбільш важливих для SEO-спеціаліста.

Допомагає дізнатися:

- Запити, за якими користувачі переходять на сайт або по яких є покази в Google, їх середню позицію і відсоток клікабельності (CTR);

- Сторінки з аналогічними параметрами;

- Країни проживання користувачів;

- Пристрої;

- Вигляд в пошуку, за яким здійснюються переходи або є покази.

За допомогою звіту про ефективність SEO-оптимізатор може:

- Провести аналіз динаміки трафіку або показів на сайті;

- Знайти слабкі місця в оптимізації;

- Виділити запити, за якими знизився або зріс трафік;

- З'ясувати, чи надходить трафік з Google Images або Google Video;

- Знайти сторінки з низьким CTR (для підвищення привабливості у видачі);

- З'ясувати, який відсоток відвідувачів переглядає сайт з мобільних пристроїв, а який з десктопних.

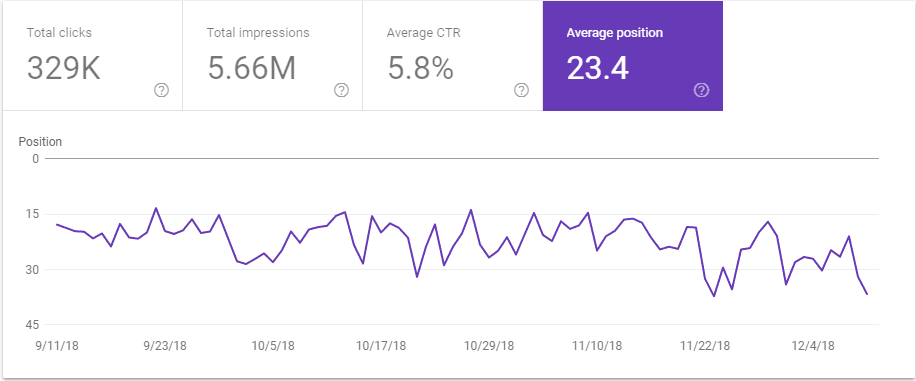

Тут важливо уточнити, що покладатися тільки на дані GSC не варто, тому що інформація не завжди точна. Для прикладу покажемо графік кліків/показів і його загальні дані при фільтрації за запитом. Після 19 серпня Google виключив рідкісні запити з підсумовуваних даних, тому картина може дуже відрізнятися від реальної.

Показник середньої позиції - теж сумнівна величина, якщо дивитися на загальну картину. Наприклад, поставивши фільтрацію по країні, ми бачимо, наскільки сильно різняться дані.

Для наближених до дійсності показників слід окремо аналізувати кожний запит і сторінку, які вас цікавлять.

Для цього використовують плагін «Search Analytics for Sheets». Його незаперечний плюс - вивантажує НЕ 1000 запитів-сторінок, а набагато більше. Як показує практичне застосування цього доповнення, воно все одно не вивантажує всю аналітику, а тільки рандомне число (від чого залежить - поки незрозуміло). Це може бути 12 000, може 18 000, а може і 7 000. Вивантаживши два звіти по зрізах (наприклад, за два тижні) і порівнявши їх, ви отримуєте повноцінну картину того, як змінилися кліки та покази по сторінці або запиту.

1.2. Звіт «Покриття» в Google Search Console

Для SEO-оптимізатора вкрай важливо, щоб всі обнародувані сторінки знаходилися в індексі пошуковика. В оновленні Google Search Console представлений деталізований звіт про індексацію сторінок, поділений на 4 великі категорії:

«Помилки» - такі сторінки не будуть проіндексовані; сюди потрапляють сторінки, закриті в <noindex>, з 5хх або 4хх відповіддю сервера або довгою вервечкою редіректів. Слідкуйте, щоб в цю групу не потрапили важливі для просування сторінки.

«Попередження» - сюди потрапляють сторінки, які закриті в robots.txt, але Google продовжує їх індексувати. Такі сторінки заважають просуванню (створюючи дублі основних), якщо бачите подібне - використовуйте <meta name = "googlebot" content = "noindex"> або X-Robots-Tag для виключення непотрібних сторінок.

«Сторінки без помилок» - корисний звіт, який допомагає визначити, які сторінки, які не вказані в Sitemap, потрапляють в індекс пошуковика, і на що витрачається краулінговий бюджет (важливо для великих сайтів-пацієнтів).

Якщо ці сторінки не приносять трафік і не потрібні в пошуку, їх закривають від індексації.

«Виключено» - спірний статус для сторінок, так як багато які з них при перевірці знаходяться в індексі Google (особливо це стосується сторінок «Сторінку проскановано, але поки не проіндексовано» і «Виявлено, що не проіндексовано»). Звіт не залишається порожнім, оскільки туди потрапляють сторінки з налаштованим «canonical», сторінки з 3хх перенаправленням і інші. Цікавий тип виключення - «Сторінка є копією. Канонічні версії сторінки, обрані Google і користувачем, не збігаються». Не ігноруйте цю проблему. Тут показано недосконалість пошукових алгоритмів. При ручній перевірці з'ясовується, що пошуковик склеює, наприклад, дві сторінки різних карток товару. Ще цей статус допомагає виявити помилку відсутності редіректу зі сторінки зі слешем на ту ж без нього (або навпаки).

Можливість дивитися статус покриття сайту по окремим Sitemap - однозначний плюс для SEO-оптимізатора в новій версії GSC, наприклад, подрібнивши мапу сайту по 1 000 URL в кожній. Таким чином, ви не пропустите сторінки, які ховаються через обмеження відображення кількості рядків в консолі.

До звіту «Покриття», як і до звіту про «Ефективність», варто ставитися як до підказок, а не доведеної істини. Перевірити ще раз отриману інформацію можна за допомогою інструменту Netpeak Checker, дізнавшись, скільки сторінок проіндексовано на сайті:

- Запускаємо сканування сайту, вибираємо пункт «Google SERP: URL».

- Значення в колонці «Індексація» показує, чи проіндексований сайт.

- У колонці «Проіндексовано» відображається кількість сторінок сайту в індексі.

Ще один момент в цьому звіті GSC, на який не варто покладатися - дата останнього сканування. Тільки лог-файли покажуть достовірну інформацію про відвідування Googlebot-ом певної сторінки. При порівнянні дат в GSC і лог-файлах видно, що вони можуть сильно відрізнятися.

Звіт «Покриття» допомагає SEO-фахівцям виявити проблеми технічного характеру на сайті:

- проблеми роботи сервера (5хх помилки);

- сторінки з 4хх відповіддю сервера;

- нескінченні редіректи;

- сторінки, помилково закриті від індексації;

- сторінки, закриті в robots.txt, але потрапили в індекс;

- дублікати і сміттєві сторінки, на які витрачається краулінговий бюджет або які знаходяться в індексі;

- важливі для просування сторінки, що не потрапили в індекс.

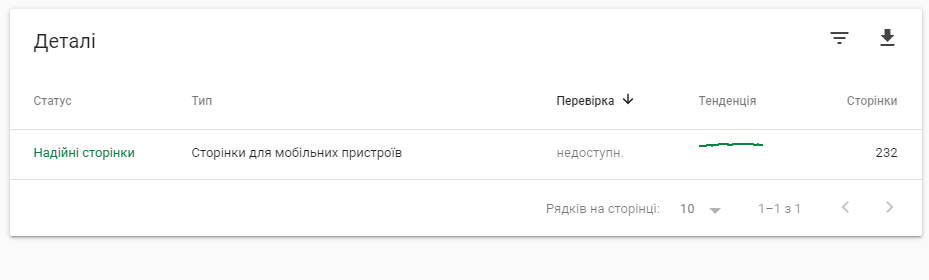

1.3. Звіти про «зручність для мобільних» і «AMP-сторінках»

В еру Mobile-First-Index для просування і ранжування в Google важливо стежити за оптимізацією сторінок під мобільні пристрої.

У цих звітах видно помилки, які варто виправити для коректного відображення на смартфонах.

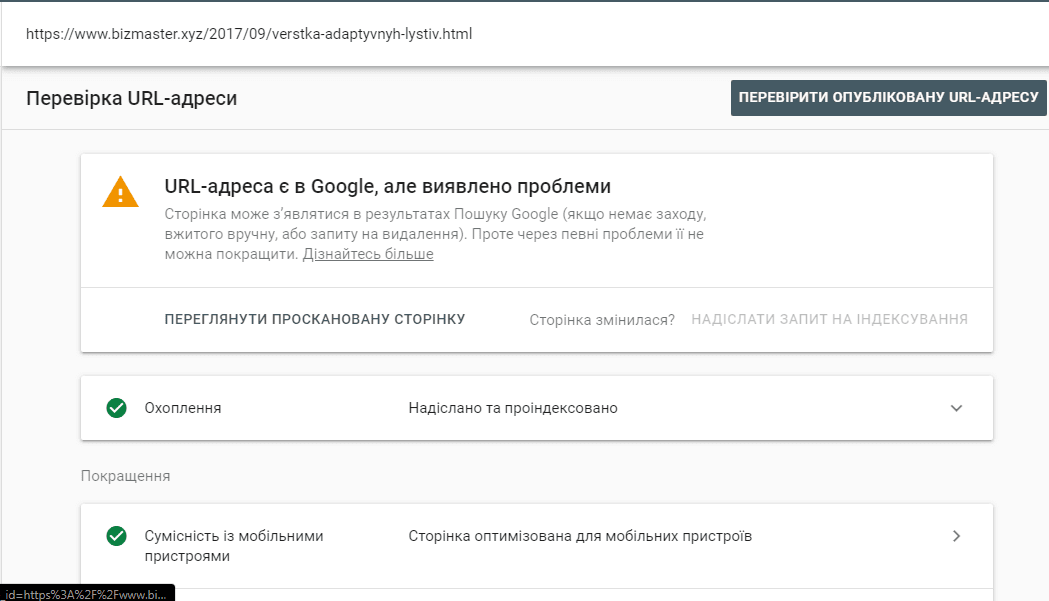

2. Функція «Перевірка URL» в новій Google Search Console

Одна з фіч, яких не вистачало в старій Google Search Console - перевірка URL. Просто надішліть URL на перевірку за допомогою цієї функції, якщо потрібно швидко перевірити одну сторінку: у індексі чи ні; якщо не в індексі, то чому; коли було останнє сканування ботом і яким (десктопним або мобільним); як виявлено сторінку..

3. Звіти у старій GSC, які все ще потрібні

Ці вкладки все ще не перенесені зі старого інструменту в новий, але менш корисними не стають. Розглянемо звіти, про які не варто забувати SEO-фахівцям.

3.1. Оптимізація HTML

Цей звіт сигналізує SEO-оптимізатора про відсутні, короткі, повторювані або довгі метадані без сканування сайту парсерами.

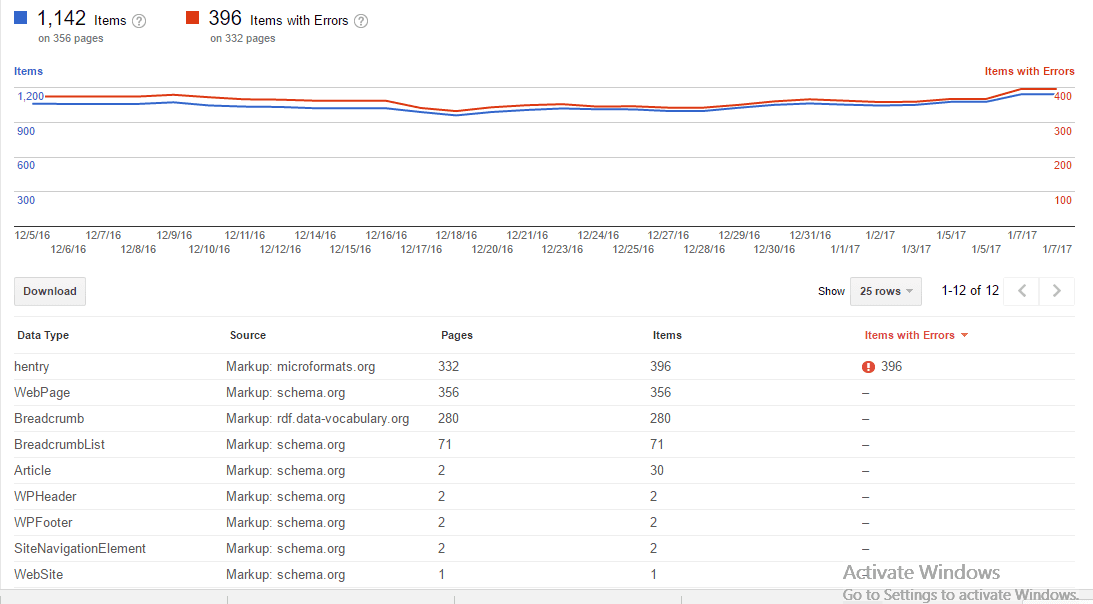

3.2. Структуровані дані

Кожен SEO-фахівець повинен знати, що в цьому звіті будуть відображені помилки, які не дають використовувати потенціал розширених фрагментів в пошуковій видачі і псують їхній вигляд.

3.3. Орієнтування за країнами і мовами

Якщо аналізований сайт-пацієнт багатомовний або мультирегіональний, то тут будуть показані помилки, пов'язані з атрибутом hreflang. Після коректного налаштування набагато легше просувати різні мовні версії сайту в цільових країнах.

3.4. Інструмент перевірки файлу robots.txt

Google Search Console допомагає протестувати файл robots.txt перед завантаженням на сайт і дізнатися:

- Чи не будуть закриті від індексації важливі сторінки;

- Чи коректно вказані директиви.

За допомогою цього інструменту ви не допустите безглузду помилку, закривши від індексації цілий каталог замість однієї сторінки.

Підведемо підсумки

Google Search Console - помічник як досвідченого, так і початківця SEO-оптимізатора, який вказує на слабкі сторони сайту-пацієнта.

Кожний фахівець визначає для себе важливість того чи іншого звіту і завдання, які ставить перед цим інструментом.

- Насамперед, побачивши різке просідання в Google, необхідно звернутися до вкладки «Заходи, прийняті вручну».

- Побачивши просідання по одній сторінці, варто аналізувати запити, за якими перестав надходити трафік.

- Помітивши у видачі нецільову сторінку, потрібно запустити «Перевірку URL».

Все це можна виконати в інструменті Google Search Console.

Обробка: Vinci